建木社区助你玩转NeMo

作者:邵嘉诚

发布时间:2023-05-29 10:00:00

在发布 ChatGLM 镜像及部署节点后,我们收到了许多用户的反馈,他们希望了解更多关于如何搭建会话 AI 模型平台。为了满足这些需求,我们决定提供一个流行的工具包——NVIDIA NeMo 的镜像及部署节点,以便于用户能更快上手并开始使用 NeMo。

什么是NeMo?

NVIDIA NeMo 是一个用于构建会话 AI 的工具包,它可以帮助研究人员在自动语音识别(ASR)、文本到语音合成(TTS)、大型语言模型(LLMs)和自然语言处理(NLP)等领域进行工作,主要目的是帮助来自工业界和学术界的研究人员重用以前的工作(代码和预训练模型),并使创建新的会话 AI 模型变得更加容易。

如何部署?

最新NeMo镜像已上传至jianmuhub,地址为https://res.jianmuhub.com/image/autoops/nemo

使用方法如下

1 | # 1.从建木镜像仓库拉镜像 |

部署完成后,就可以得到一个预装NeMo的jupyterLab环境,登陆后如下:

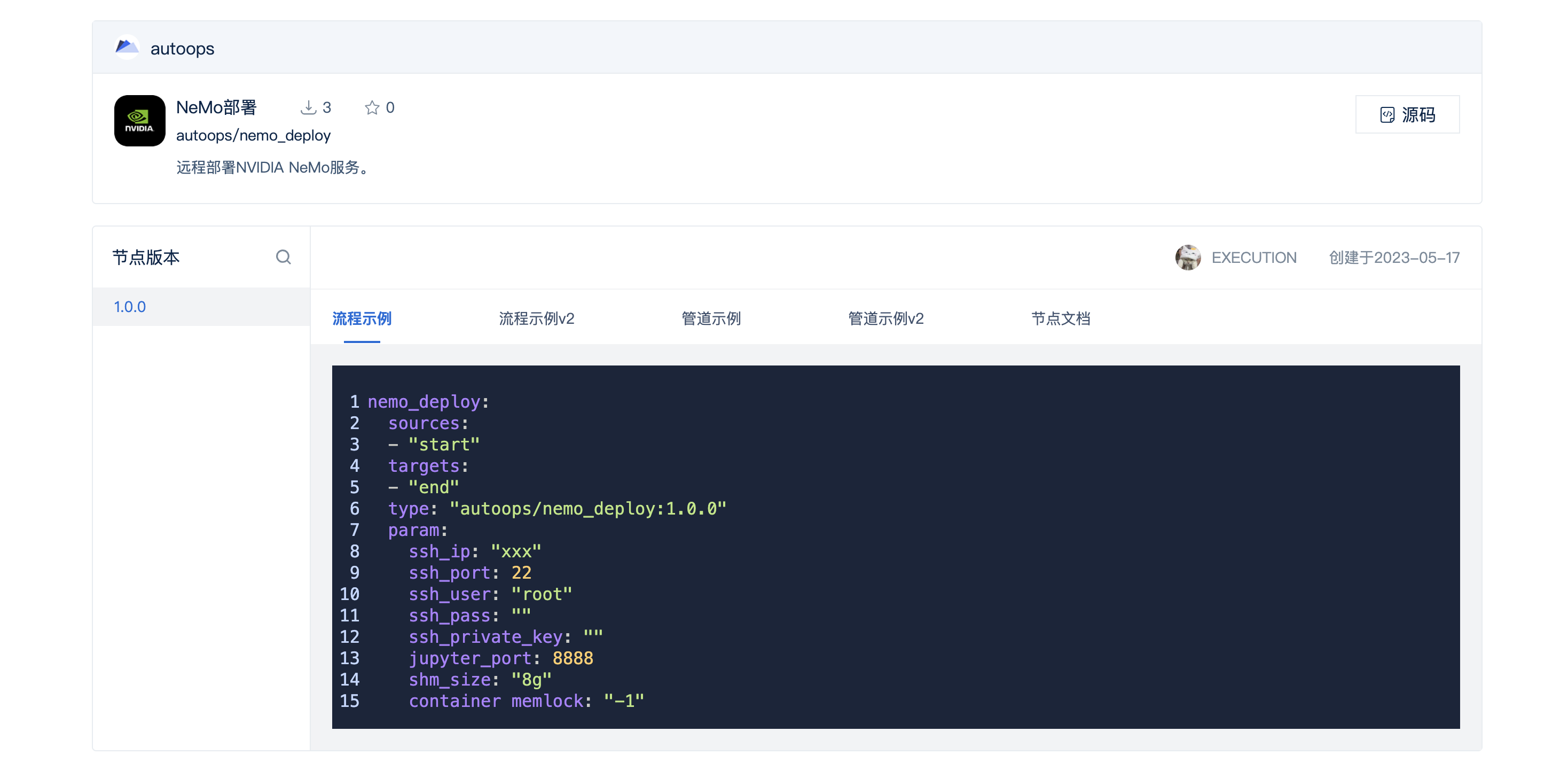

如何通过建木节点部署?

NeMo部署节点在建木hub的地址:https://jianmuhub.com/autoops/nemo_deploy

该节点可在指定IP的Linux服务上远程部署NeMo并启动jupyter服务,默认指定容器共享内存大小为8g,内存无限制,堆栈大小为64mb,可根据实际配置自行修改。部署要求服务器已安装docker,nvidia驱动及nvidia容器运行时,具体要求参照节点仓库readme。

部署过程中遇到任何问题,欢迎开issue或者加入建木社区用户群交流。

如何使用NeMo

部署完成后,即可通过NeMo调用会话AI的相关模型,这里提供一个调用asr模型进行音频转文字的样例,代码如下:

1 | import nemo.collections.asr as nemo_asr |

执行结果如下:

1 | ['我们尽了最大努力'] |

最后

本次分享内容介绍到这就结束啦!未来,建木社区将更加努力地推进大模型对话技术的发展,为用户提供更加优质的服务。